Autonomous Tram System: An Innovative Collaboration between ITB and INKA

Bambang Riyanto Trilaksono

Sekolah Teknik Elektro dan Informatika-ITB, Center for Artificial Intelligence-ITB

Ari Wibowo

Sekolah Teknik Elektro dan Informatika-ITB

A. Pendahuluan

Dalam era perkembangan teknologi yang pesat, transportasi merupakan salah satu sektor yang terus mengalami transformasi. Sebagai upaya menghadirkan solusi yang inovatif dan ramah lingkungan, Institut Teknologi Bandung (ITB) dan PT Industri Kereta Api (INKA) menjalin kemitraan untuk mengembangkan sistem autonomous trem. Inisiatif ini bukan hanya menciptakan solusi transportasi modern, tetapi juga mendorong kemajuan teknologi di Indonesia. Transportasi umum yang aman dan nyaman merupakan elemen penting dari infrastruktur kota. Mengingat beberapa faktor, seperti kemacetan lalu lintas, masalah lingkungan, dan pertumbuhan kota yang pesat, transportasi umum harus menjadi cara yang paling menarik untuk berkeliling kota. Meningkatnya perhatian terhadap mobilitas listrik dan kepekaan yang lebih besar terhadap masalah lingkungan telah mendukung penyebaran trem dalam beberapa tahun terakhir (Pemerintah Kota Bogor, Provinsi Bali, dan Kota Surabaya) telah tertarik untuk menggunakan trem sebagai transportasi perkotaan mereka (sumber: internal PT INKA). Hal ini mungkin saja akan diikuti oleh berbagai kota lain di Indonesia, sehingga potensi kendaraan trem yang harus diproduksi menjadi meningkat pesat. Istilah trem digunakan untuk angkutan umum kereta yang jalurnya sejajar dan berada di jalan raya. Ini berarti bahwa trem harus berbaur dengan sarana transportasi lain, seperti mobil dan sepeda motor, serta pejalan kaki. Dalam operasinya, trem harus membatasi kecepatannya untuk menghindari kecelakaan dengan alat transportasi lain yang menggunakan jalan raya. Selain membatasi kecepatan, trem juga biasanya terbatas pada jumlah gerbong yang hanya terdiri dari satu atau dua gerbong sehingga tidak mengganggu arus lalu lintas dan umumnya memiliki kapasitas antara 125–250 penumpang.

Saat ini masalah kecelakaan kereta api di Indonesia yang tinggi, terutama akibat kelelahan atau mengantuk masinis. Solusi yang diajukan adalah menambahkan sistem assistant driver pada kereta atau trem, bahkan mengembangkan trem yang dapat berjalan secara otonom untuk meningkatkan keselamatan dan efisiensi transportasi publik. Kendaraan otonom dianggap sebagai solusi efektif untuk mengatasi masalah kecelakaan akibat kondisi pengemudi yang tidak optimal. Artikel ini akan membahas aspek riset dan inovasi terkait kendaraan otonom, dengan fokus pada pengembangan trem otonom. Pembahasan mencakup pengembangan sistem otonomi, termasuk deep learning dan perangkat lunak serta perangkat keras yang dirancang. Hasil pengujian dari assisted driving system pada trem otonom juga akan dijelaskan, diikuti oleh kesimpulan dan pelajaran yang dipetik dari pengembangan trem otonom dengan kecerdasan buatan.

B. Trem Otonom

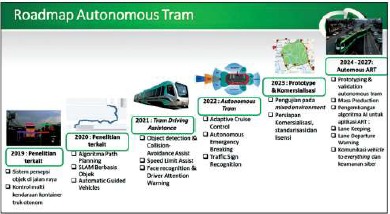

Berdasarkan pertimbangan di atas, Institut Teknologi Bandung (ITB) menjalin kerja sama strategis dengan PT Industri Kereta Api (PT INKA) dan perusahaan riset kecerdasan buatan dalam proyek riset inovatif berjudul “Pengembangan Sistem Otonomi dengan Menggunakan Kecerdasan Artifisial untuk Trem Otonom.” Proyek ini mendapatkan pendanaan dari Lembaga Pengelola Dana Pendidikan (LPDP) dalam skema riset inovatif produktif. Dalam konteks kerja sama ini, ITB mengambil peran utama dalam pengembangan sistem otonomi. Ini mencakup perancangan dan pengembangan AI pipeline, perangkat lunak, serta perangkat keras, termasuk sensor dengan embedded graphical processing unit (GPU). Di samping itu, PT INKA turut berkontribusi dengan menyediakan trem berbasis listrik dan sistem drive-by-wire, serta menyediakan lingkungan pengujian di Madiun. Lebih lanjut, riset kecerdasan buatan terlibat dalam pengembangan model AI khusus untuk pengenalan wajah dan peringatan atensi masinis. Mereka juga memiliki peran penting dalam pengawasan dan analisis data yang digunakan dalam rekayasa sistem. Peta jalan riset dan inovasi telah dirancang untuk mencakup tahapan riset yang telah dilakukan, sedang berlangsung, dan akan dilakukan. Gambar 1 menggambarkan secara visual peta jalan tersebut.

Dalam kurun waktu 2021-2023, fokus utama proyek ini adalah pengembangan sistem otonomi trem. Setelah itu, pada periode 2024-2027, proyek ini akan memperluas cakupannya dengan melibatkan pengembangan Autonomous Rail Rapid Transit (ART). Dengan demikian, proyek ini tidak hanya memberikan solusi untuk trem otonom, tetapi juga merencanakan penerapan teknologi otonom dalam moda transportasi rel yang lebih luas. Keseluruhan proyek ini memiliki tujuan jangka panjang untuk meningkatkan keamanan dan efisiensi transportasi publik di Indonesia. Seperti diperlihatkan pada Gambar 1, telah dilakukan beberapa riset terkait dengan deteksi dan klasifikasi serta penjejakan objek lalu lintas berdasarkan kamera sebagai elemen penting dari kendaraan otonom [1][2][18][19][20]. Beberapa model deep learning telah dikembangkan untuk mendukung riset tersebut, salah satunya berbasis Yolo untuk mendeteksi objek lalu lintas yang beragam, sebagaimana banyak dijumpai di Indonesia. Deep learning merupakan paradigma penting dalam kecerdasan artifisial yang berkembang dalam beberapa tahun terakhir dan didasarkan pada model dan prinsip kerja otak makhluk hidup secara umum, dan manusia secara khusus, yang disusun ke dalam sejumlah besar lapisan neuron [2][3][4][9].

C. Sistem Autonomous Trem

Sistem autonomous trem ini didukung oleh teknologi-teknologi canggih seperti sensor-sensor pintar, kecerdasan buatan (AI), dan pemrosesan data real-time. Sensor-sensor pintar yang terpasang pada trem dapat mendeteksi kondisi jalan, kendaraan di sekitarnya, dan perubahan lingkungan sekitar. Informasi yang diperoleh dari sensor-sensor tersebut akan diolah oleh sistem kecerdasan buatan untuk membuat keputusan yang tepat, termasuk navigasi dan pengendalian kecepatan trem. Sebagai kendaraan mandiri, trem otonom harus memiliki kemampuan untuk mendeteksi objek berdasarkan sensor yang digunakan dan dapat melakukan penghindaran terhadap halangan. Hal ini penting karena trem otonom beroperasi di lingkungan jalan raya yang bercampur dengan berbagai jenis kendaraan seperti mobil, angkot, sepeda motor, sepeda, bus, truk, dan pejalan kaki. Berbagai sensor dirancang dan digunakan pada trem otonom, termasuk sensor kamera, sensor LIDAR, dan sensor radar. Masing-masing sensor memiliki karakteristik unik yang saling melengkapi. Trem otonom juga harus mampu beroperasi dengan mematuhi batas kecepatan yang diizinkan pada ruas jalan rel tertentu. Hal ini diperlukan agar trem tidak membahayakan, terutama di situasi seperti kemiringan jalan rel. Proses pengembangan trem otonom dilakukan dalam dua tahap, yakni perancangan tram driving assistance pada periode 2021-2022 dan pengembangan trem otonom pada periode 2022-2023.

Tram driving assistance dapat dianggap sebagai sistem semi-otonom yang berfungsi sebagai bantuan untuk masinis, terutama pada kondisi tertentu yang dianggap berbahaya. Sistem ini perlu dikembangkan terutama pada trem yang beroperasi di Indonesia, mengingat kecenderungan sebagian pengguna lalu lintas di negara ini yang tidak selalu menaati peraturan lalu lintas. Sistem otonomi pada tram driving assistance perlu dilengkapi dengan kemampuan untuk mengenali wajah masinis dan memberikan peringatan atensi masinis. Kemampuan ini menjadi krusial dalam situasi di mana masinis mengalami kelelahan atau kehilangan konsentrasi saat mengoperasikan trem. Sistem peringatan atensi harus mampu mendeteksi ketidakfokusan masinis. Selain itu, pada tahap pengembangan trem otonom, beberapa fitur telah ditambahkan pada sistem otonominya. Fitur-fitur tersebut meliputi adaptive cruise control, obstacle avoidence, dan autonomous emergency braking. Semua fitur ini dirancang untuk meningkatkan keamanan dan efisiensi trem otonom, sehingga dapat memberikan kontribusi positif terhadap transportasi publik di Indonesia.

Untuk merealisasikan tram driving assistance, dikembangkan model deep learning yang memiliki kemampuan mendeteksi objek di sekitar trem dan melakukan pelacakan dengan memanfaatkan sensor kamera, LiDAR, dan radar yang diimplementasikan pada modul persepsi dari sistem otonomi yang dikembangkan. Jenis objek yang perlu dideteksi adalah sepeda motor, mobil, angkot, truk, bus, dan pejalan kaki. Model deep learning berbasis convolutional neural networks juga dikembangkan untuk mengidentifikasi wajah melalui kamera yang dipasang di ruang masinis dan dapat mengidentifikasi siapa yang menjadi masinis. Sistem peringatan juga direalisasikan dengan menggunakan model deep learning untuk mendeteksi apakah masinis sedang mengantuk atau atensinya sedang terganggu.

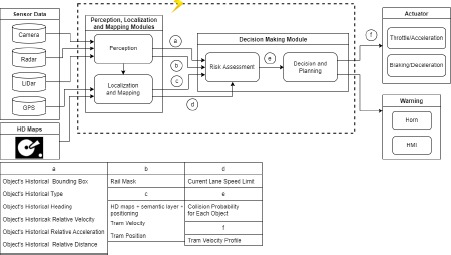

Diagram blok rancangan sistem otonomi untuk trem otonom yang dikembangkan diperlihatkan pada Gambar 2. Sebagaimana diperlihatkan pada gambar tersebut, sistem otonomi untuk trem otonom dilengkapi dengan sejumlah sensor, seperti kamera, LiDAR, dan radar. Sensor sejenis ini diperlukan karena trem otonom beroperasi pada lingkungan mixed traffic, atau dengan kata lain, beroperasi di samping atau di tengah jalan raya bersama-sama dengan berbagai jenis kendaraan lain, seperti sepeda, sepeda motor, angkot, mobil, bus, dan truk, atau pejalan kaki. Instalasi sensor pada trem otonom dan penempatannya diperlihatkan pada Gambar 3 (a), sedangkan Gambar 3 (b) adalah penempatan sensor pada kendaraan testbed untuk simulasi dan pengujian sebelum dipasang pada trem. Penggunaan sensor kamera, LiDAR, dan radar pada kondisi lalu lintas seperti ini diperlukan untuk mempersepsi lingkungan yang ada di sekitar trem otonom. Secara khusus, sistem persepsi yang dilengkapi dengan sensor tersebut memiliki kemampuan untuk mendeteksi dan mengklasifikasi objek di sekitarnya. Deteksi objek dilakukan dengan membentuk bounding box berbentuk dua atau tiga dimensi menggunakan deep learning berdasarkan sensor kamera, LiDAR, dan radar. Contoh inferensi model deep learning yang dikembangkan pada video yang ditangkap oleh kamera diperlihatkan pada Gambar 4.

Metode deteksi objek berbasis kamera bekerja menggunakan gambar sebagai input untuk menghasilkan informasi tentang objek yang berada di lingkungan kendaraan otonom. Pengembangan metode deteksi objek ini sangat penting dalam kendaraan otonom, karena memerlukan pendeteksian dengan akurasi dan kecepatan yang tinggi. Metode deteksi objek berbasis kamera dapat dibagi menjadi dua jenis, yaitu metode berbasis gambar tunggal atau kamera monokular (monocular-camerabased) dan metode berbasis beberapa gambar atau kamera stereo (stereo-camerabased). Metode berbasis gambar tunggal hanya menggunakan satu gambar untuk mendapatkan informasi tentang objek 2D, sedangkan metode stereo menggunakan dua gambar atau lebih untuk menghasilkan informasi yang lebih akurat bahkan dapat menghasilkan deteksi objek 3D. Beberapa kelebihan metode deteksi objek berbasis kamera monokular meliputi kemudahan implementasi, biaya yang lebih rendah dibandingkan dengan sensor kamera stereo, LiDAR atau radar. Namun, beberapa kelemahan metode ini adalah tidak dapat mendapatkan kedalaman objek dengan baik, keakuratan yang terbatas terutama pada jarak jauh, terpengaruh oleh kondisi cahaya dan cuaca, serta rentan terhadap oklusi.

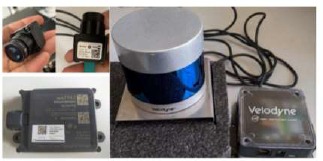

Kamera yang digunakan pada penelitian ini adalah Kamera Sekonix SF3325-100, kamera tersebut merupakan jenis kamera monokular wide-angle yang memiliki sudut pandang horizontal 60°. Kamera ini mampu memproses gambar dengan kecepatan mencapai 30 gambar per detik atau frame per second (FPS). Selain itu kamera Sekonix SF3325-100 ini merupakan jenis kamera yang mampu bekerja pada suhu penyimpanan hingga 105°C dan ketahanan perlindungan yaitu IP69K. Sedangkan untuk LiDAR digunakan jenis produksi dari Velodyne Inc dengan tipe VLP-32C. LiDAR ini mampu bekerja dengan kecepatan 5 – 20 Hz dengan jumlah kanal sebanyak 32. LiDAR ini menghasilkan pemindaian dengan sudut pandang horizontal 360°. Sensor berikutnya yang digunakan untuk sistem persepsi adalah radar, jenis radar yang digunakan adalah radar Continental ARS430RDI. Jenis radar ini merupakan radar otomotif yang beroperasi pada frekuensi 77 GHz. ARS430RDI memiliki 2 wilayah pengindraan yang bekerja secara bersamaan. ARS430RDI dapat mendeteksi objek dengan elevasi 14 dan 20 derajat dari permukaan tanah masing-masing untuk wilayah pengindraan jauh dan dekat. Daftar sensor yang digunakan pada sistem persepsi trem otonom ditunjukkan pada Gambar 5.

Pada sistem persepsi, juga dikembangkan segmentasi citra, yang berfungsi untuk meningkatan “kecerdasan” sistem persepsi. Sebagai contoh dengan menggunakan salah satu metoda dalam segmentasi citra yaitu segmentasi panoptik (panoptic image segmentation) berbasis deep learning, sistem otonomi dapat membedakan citra yang merupakan pepohonan, bangunan, udara, objek kendaraan di sekitar trem otonom, maupun bidang jalan (drivable area). Hasil inferensi model deep learning untuk segmentasi citra ini diperlihatkan pada Gambar 6. Gambar kiri memperlihatkan segmentasi citra terhadap objek kendaraan dan pepohonan. Gambar kanan memperlihatkan segmentasi citra untuk menentukan bidang/wilayah dimana kendaraan dapat beroperasi. Sebagaimana terlihat pada gambar ini model deep learning yang dikembangkan dapat membangun pemisahan citra dari objek kendaraan, pepohonan, maupun bidang jalan yang dapat dilalui kendaraan otonom. Selain kemampuan mendeteksi objek, dikembangkan juga sistem pengenalan rambu lalu-lintas berdasarkan citra yang ditangkap oleh kamera. Sistem ini juga menggunakan model deep learning, sehingga memiliki kemampuan untuk mendeteksi rambu atau semboyan yang digunakan sepanjang rel kereta otonom, termasuk diantaranya adalah kemampuan mendeteksi rambu pada situasi yang agak ekstrim, seperti pencahayaan yang agak redup, misalnya pada sore hari, atau pada situasi ketika ada hujan rintik-rintik.

Sistem persepsi ini selanjutnya berhubungan dengan sistem lokalisasi dan pemetaan. Sistem lokalisasi diperlukan untuk menentukan koordinat lokasi dari trem otonom dalam peta. Penentuan lokasi yang akurat sangat penting pada kendaraan otonom. Sistem ini menghitung koordinat lokasi berdasarkan sensor GPS dan IMU dengan tingkat ketelitian tertentu, yaitu dalam kasus trem otonom yang dikembangkan akurasinya dibawah 10cm. Ada dua jenis GPS yang digunakan, yang pertama dengan memanfaatkan satelit, yang kedua dengan berbasis RTK. Untuk peta digunakan Open Streetmap yang bersifat terbuka. Informasi lokasi trem otonom selanjutnya ditunjukkan pada peta dan ditampilkan pada suatu display.

Dengan mendasarkan pada sistem deteksi objek, lokalisasi dan peta, sistem pengambilan keputusan pada sistem otonomi akan melakukan beberapa keputusan seperti melakukan percepatan, pelambatan trem, membunyikan buzzer di ruang masinis, maupun membunyikan horn. Modul pengambil keputusan terdiri dari safety assessment, pembuatan keputusan dan sistem kendali. Safety assessment memungkinkan sistem otonomi untuk melakukan penilaian seberapa tingkat bahaya situasi tertentu di sekitar trem otonom. Penilaian ini dinyatakan dalam bentuk nilai probabilitas bahaya situasi tertentu, dengan mendasarkan pada prediksi trajektori objek (kendaraan) dan posisi serta kecepatan trem otonom. Sistem ini dirancang sehingga merealisasikan fitur penting dari kendaraan otonom, seperti emergency braking system dan collision avoidance. Dikembangkan juga fitur adaptive cruise control yang memungkinkan trem otonom mengatur jarak (dan kecepatan) aman terhadap trem lain yang melaju didepannya. Salah satu metoda kendali yang digunakan adalan MPC (Model Predictive Control).

Beberapa kelebihan metode deteksi objek berbasis kamera monokular meliputi kemudahan implementasi, biaya yang lebih rendah dibandingkan dengan sensor kamera stereo, LiDAR atau radar. Namun, beberapa kelemahan metode ini adalah tidak dapat mendapatkan kedalaman objek dengan baik, keakuratan yang terbatas terutama pada jarak jauh, terpengaruh oleh kondisi cahaya dan cuaca, serta rentan terhadap oklusi. Oleh karena itu diperlukan sensor Lidar dan radar untuk mendapat informasi dari objek 3D yang lebih lengkap. Deteksi objek berbasis pada LiDAR saja, mendapatkan informasi yang lebih banyak dibandingkan dengan hanya menggunakan kamera. Dengan menghitung pola balikan laser, sensor LiDAR dapat membuat representasi titik awan 3D dari lingkungan sekitar. Sistem deteksi objek berbasis LiDAR ini dapat menghasilkan kotak pembatas 3D yang menunjukkan posisi, ukuran, dan orientasi objek di sekitar kendaraan otonom (Simony, M. et al., 2018). Metode deteksi objek hanya berbasis LiDAR memiliki beberapa keunggulan dibandingkan dengan metode berbasis kamera, termasuk akurasi dan keandalan yang tinggi, independen dari kondisi pencahayaan, dan kemampuan untuk mendeteksi objek pada jarak yang lebih jauh. Metode ini juga kurang terpengaruh oleh oklusi objek dan dapat mendeteksi objek dengan reflektivitas rendah atau kendaraan berwarna gelap [22].

Penelitian ini juga mengembangkan model yang memanfaatkan fusi kamera dengan LiDAR, pendeteksian objek 3D berbasis fusi kamera dan LiDAR sangat popular belakangan ini untuk pengembangan kendaraan otonom. Metode ini juga dikenal dengan penggunakan multi-sensor. Penggunaan metode yang hanya mengandalkan satu jenis sensor seperti LiDAR atau kamera seringkali menghasilkan deteksi yang kurang memuaskan dalam beberapa kasus, terutama ketika kondisi pencahayaan kurang baik atau terdapat objek yang menghalangi. Oleh karena itu, penggunaan multi-sensor menjadi solusi yang lebih baik untuk mendapatkan hasil yang lebih 20 akurat dan dapat diandalkan. Penggabungan kedua informasi data dari kedua sensor kamera dan LiDAR digunakan untuk mendapatkan informasi 3D yang lebih lengkap dan terperinci tentang lingkungan sekitar. Pendekatan ini memungkinkan untuk mengkombinasikan kelebihan dari masing-masing sensor. LiDAR dapat memberikan informasi yang sangat akurat tentang jarak dan posisi objek di sekitar kendaraan otonom, dimana hal ini mampu mengatasi masalah keterbatasan jangkauan dan ketidakmampuan mengidentifikasi objek pada kondisi pencahayaan yang rendah pada kamera, sedangkan kamera mampu memberikan informasi yang lebih kaya tentang ciri-ciri visual seperti warna, tekstur, dan pola yang merupakan keterbatasan pada data LiDAR [23].

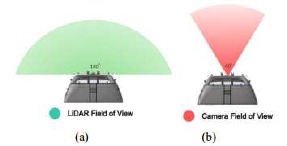

Berdasarkan spesifikasi perangkat keras sensor yang digunakan serta penempatan sensor pada trem, maka dalam penelitian ini memiliki batasan dalam jangkauan penglihatan atau field of view (FOV) sistem yang dikembangkan. Secara sederhana FOV dari keluaran sistem persepsi penelitian ini dapat digambarkan pada Gambar 7 berikut ini.

Sistem deteksi 3D dari LiDAR akan menghasilkan kotak pembatas 3D (x,y,z,w,h,l) berdasarkan klasifikasinya (k) beserta orientasi (𝜃) dan skor kepercayaan deteksi (s), seperti yang terlihat pada Gambar 8. Kotak pembatas 3D dalam koordinat LiDAR tersebut dapat diproyeksikan dengan akurat ke bidang gambar dengan menggunakan parameter kalibrasi antara kamera dan LiDAR, sebagaimana ditunjukkan pada Gambar 9.

Selain itu pada deteksi objek berbasis pada kamera, proses pendeteksian objek 2D lebih cepat dibandingkan pendeteksian objek 3D. Dalam penelitian ini, fusi kamera-LiDAR yang dilakukan adalah pada tahap late-fusion atau tahap keputusan (decision level). Metode fusi pada tahap ini akan berfokus untuk meningkatkan average precision (AP) dengan cara memperbaiki atau melakukan koreksi dari masing-masing detektor tunggal. Sehingga, pada deteksi kamera tidak dibutuhkan deteksi objek 3D.

Namun, karena data keluaran deteksi objek 2D dan 3D berbeda, maka proses asosiasi akan dilakukan pada bidang yang sama, yaitu di bidang gambar. Hal ini dapat dilakukan karena proyeksi kotak pembatas 3D ke bidang gambar 2D dapat sangat presisi dilakukan dengan bantuan beberapa parameter kalibrasi [24].

D. Implementasi Sistem Autonomous

Seluruh AI pipeline dan algoritma yang digunakan pada sistem otonomi yang dirancang ini diimplementasikan pada Nvidia GPU Driveworks (Pegasus). Nvidia GPU Driveworks dengan nama Pegasus merupakan embedded GPU yang dikembangkan untuk kendaraan otonom yang mengandung beberapa GPU dalam satu board. Penting disampaikan disini bahwa pada penerapan dan deployment model deep learning, pengembangan model deep learning sebagaimana yang umumnya dilakukan di lingkungan akademik tidaklah cukup. Model-model AI yang dikembangkan ini perlu di-deploy dan diuji pada platform komputasi yang digunakan pada deployment sistem ini, dalam kasus ini adalah Embedded GPU Driveworks. Pada umumnya, pengembangan model deep learning pada projek riset dan inovasi ini dilakukan melalui beberapa tahap :

- Pengembangan model deep learning melalui transfer learning dari suatu pretrained model atau modifikasi dari model deep learning yang sudah dikembangkan para peneliti dan dilatih dengan memanfaatkan dataset yang tersedia online seperti Kitti dan NuScene, selanjutnya dilatih terhadap dataset lokal yang diambil dan dikembangkan oleh tim riset. Model deep learning ini dikembangkan pada suatu server dengan beberapa GPU. Pengembangan dilakukan dengan TensorFlow atau Pytorch.

- Pengembangan model deep learning pada server dan GPU dengan lingkungan perangkat lunak (Nvidia Driveworks) yang sama seperti pada Nvidia Embedded GPU Drive (Pegasus) yang digunakan. Dalam hal ini menggunakan TensorRT dengan versi yang sama.

- Implementasi AI pipeline dan algoritma terkait pada Nvidia Embedded GPU Driveworks dengan menggunakan TensorRT.

Secara khusus pada Langkah 3) dilakukan assessement bukan saja terkait dengan kinerja model deep learning yang dikembangkan, misalnya akurasi, recall, f1-score dan lain-lain, tetapi juga kecepatan komputasi, misalnya dalam bentuk fps (frame per-detik). Evaluasi ini sangat penting karena model deep learning yang diimplementasikan pada Embedded GPU akan diterapkan pada safety-critical system yaitu trem otonom, dimana respons waktu dari berbagai model atau algoritma sangat perlu diperhatikan. Dalam hal ini, seringkali terjadi kompromi antara kinerja model deep learning dengan waktu komputasinya. Dalam beberapa hal seringkali kita tidak dapat mengembangkan dan menggunakan model deep learning yang paling canggih dan terkini karena dibatasi oleh versi TensorRT yang digunakan pada Embedded GPU. Dalam beberapa hal, suatu kompromi atau trade-off dalam desain dan deployment AI perlu dilakukan.

Secara umum, pengembangan model deep learning dan AI pipeline dan simulasinya dilakukan di ITB dan Riset Kecerdasan Buatan. Sementara integrasi pada platform trem dilakukan di PT INKA, Madiun. Pengambilan data lingkungan dengan menggunakan sensor kamera, lidar dan radar dilakukan di beberapa lokasi : 1) Jalanan Bandung, 2) Solo (pada ruas rel trem Bathara Kresna), 3) PT INKA. Pengambilan data jalanan di Bandung dimaksudkan untuk memperoleh data video dan data lidar untuk deteksi objek, termasuk dalam kondisi agak ekstrim yaitu pada kondisi hujan dan agak gelap (sore menjelang malam hari). Pengambilan data di Solo menggunakan dressin yang mirip dengan trem listrik yang dikembangkan sistem otonominya, dan terpasang sensor kamera, lidar dan radar. Pengambilan data di Solo ini dimasudkan untuk merepresentasikan kondisi lingkungan sesungguhnya pada jalur trem Bathara Kresna yang bersifat mixed traffic, termasuk berbagai objek kendaraan, pejalan kaki, dan berbagai rambu atau semboyan yang digunakan di jalur rel trem. Pengambilan data di PT INKA, Madiun, dimaksudkan untuk merepresentasikan data dengan penempatan sensor yang sesungguhnya di trem yang dikembangkan sistem otonominya. Ketiga jenis dataset ini digunakan untuk melengkapi data set yang tersedia secara online seperti Kitti, NuScene, FRSign[9] yang merepresentasikan kondisi di negara maju, sementara ketiga jenis data yang diambil sendiri merepresentasikan data lokal yang khas Indonesia. Mengingat pentingnya data yang diperoleh dari sensor-sensor ini, tim riset dan inovasi membentuk tim khusus rekayasa data, yang bertugas mengelola data, melakukan pelabelan/anotasi, dan menyiapkan dataset yang diperlukan untuk membangun berbagai jenis model deep learning. Tersedianya dataset yang bagus dalam jumlah cukup besar sangat penting dalam pengembangan model deep learning[2-4,13,18-20].

Integrasi sensor kamera, GPS, IMU, dan embedded GPU serta drive-by-wire system pada trem listrik dilakukan di PT INKA seperti ditunjukkan pada Gambar 10. Fine tuning algoritma lebih lanjut juga dilakukan pada tahap ini. Secara khusus dilakukan komunikasi antara embedded GPU dengan drive-by-wire system, untuk memastikan perintah yang diberikan oleh Embedded GPU dalam berbagai jenisnya (percepatan, pelambatan, perintah membunyikan buzzer dan mebunyikan horn) dapat dilaksanakan oleh trem melalui drive-by-wire system. Pada tahun pertama riset dan inovasi ini dilakukan pengembangan driver assisted system. Terdapat beberapa fitur yang dibuat, yaitu 1) deteksi objek dengan menggunakan kamera, 2) collision avoidance assist, 3) speed limit assist, 4) pengenalan wajah masinis, 5) peringatan atensi driver. Sedangkan pada tahun kedua dikembangkan 1) deteksi objek menggunakan fusi kamera-lidar, 2) adaftif cruise control, 3) fully autonomous trem system.

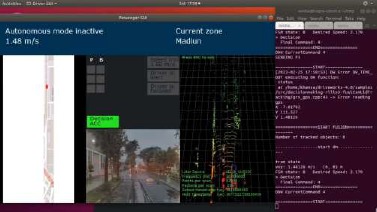

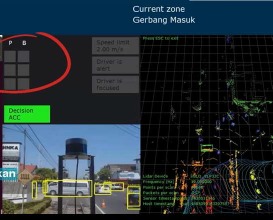

Metode deteksi objek berbasis fusi kamera – LiDAR yang diimplementasikan pada komputer embedded Nvidi Drive AGX Pegasus menggabungkan arsitektur CenterPoint [25] dan YOLOv3 [26]. Masing – masing arsitektur ini mampu melakukan deteksi objek yang berada di jalan raya seperti kelas car, truck, pedestrian dan cyclist. Implementasi metode fusi yang dilakukan pada komputer embedded menggunakan bahasa pemrograman C++ dengan menggunakan perangkat keras ii LiDAR Velodyne VLP-32C dan sensor kamera Sekonix SF3325-100. Program fusi ini digabungkan dengan program utama yang diimplementasikan pada trem otonom. Keluaran metode fusi ini akan digunakan oleh sistem pengambilan keputusan pada kendaraan otonom untuk melakukan aksi. Gambar 11 berikut ini merupakan Graphical User Interface (GUI) dari implementasi pada komputer embedded untuk fusi kamera – LiDAR.

Dapat dilihat pada Gambar 11, pada sisi sebelah kanan merupakan tampilan dari point cloud yang dibentuk dari data sensor LiDAR Velodyne VLP-32C. Kemudian pada sisi tengah bagian bawah merupakan tampilan dari gambar yang diperoleh dari sensor kamera Sekonix SF3325-100. Sedangkan dibagian sebelah kiri merupakan peta dan lokasi kendaraan berada yang diperoleh dari sensor GPS.

E. Pengujian

Perlu kiranya disampaikan bahwa sebelum melakukan pengujian secara terintegrasi di lapangan, dikembangkan suatu lingkungan simulasi yang melibatkan dua platform komputasi: 1) pc server yang terinstalasi Carla, dan 2) Nvidia Embedded GPU. Carla adalah lingkungan simulasi dan animasi yang biasa digunakan pada pengembangan kendaraan otonom. Kedua platform komputasi ini diintegrasikan dengan Carla untuk menampilkan animasi kendaraan di suatu lingkungan perkotaan, dan AI pipeline yang diimplementasikan pd Nvidia Embedded GPU. Dengan menggunakan lingkungan simulasi seperti ini, berbagai macam skenario beroperasinya trem otonom dapat dilakukan, termasuk pada situasi dimana tidak dapat dilakukan pengujian riil di lapangan karena berbagai keterbatasan.

Pengujian performa metode deteksi objek 3D berbasis fusi kamera – LiDAR yang dikembangkan pada penelitian ini dievaluasi pada dataset publik KITTI. Dataset KITTI telah menyiapkan beberapa kelompok sampel yang terdiri dari sampel pelatihan (training set) berjumlah 7481 dan sampel pengujian (test set) berjumlah 7518. Khusus untuk sampel pengujian tidak tersedia label ground truth. Sehingga untuk perhitungan performa dilakukan langsung dengan mengirimkan hasil deteksi ke server resmi KITTI Dataset. Sedangkan untuk sampel pelatihan tersedia label ground truth yang dibagi kembali menjadi 3712 sampel pelatihan dan 3769 sampel validasi.

Metode fusi kamera – LiDAR yang dikembangkan pada penelitian ini mampu melakukan fusi untuk mendeteksi objek 3D. Dengan menggabungkan beberapa kombinasi metode deteksi objek 2D berbasis kamera dan metode deteksi objek 3D, metode fusi yang dikembangkan menunjukkan performa yang meningkat dibandingkan dengan baseline yang digunakan saat melakukan fusi. Keberhasilan metode fusi yang diuji dengan beberapa kombinasi metode deteksi objek ini menunjukkan bahwa arsitektur metode fusi dapat digunakan secara modular atau dapat digabungkan dan dipisahkan dengan berbagai sistem yang lainnya dengan berbagai jenis metode deteksi objek. Secara umum, berdasarkan tersebut performa deteksi berbasis fusi kamera – LiDAR yang tertinggi didapatkan saat kombinasi SECOND – YOLOv3 dengan mAP 91,15% untuk BEV mAP, dan 84,74% untuk 3D mAP.

Pengujian sistem fully autonomous pada trem dilaksanakan di Jalan Yos Sudarso, Madiun, sebuah langkah signifikan dalam menguji dan mengimplementasikan teknologi otonom di lingkungan nyata. Pengujian dilakukan dengan mempertimbangkan berbagai hambatan yang mungkin muncul di jalan, seperti pejalan kaki, sepeda motor, dan mobil, seperti ditunjukkan pada Gambar 12. Sedangkan tampilan antarmuka sistem fully autonomous ditunjukkan pada Gambar 13. Berbagai hambatan yang dapat dihadapi, seperti pejalan kaki yang mendadak muncul di lintasan trem, sepeda motor yang melakukan manuver, serta mobil yang berinteraksi dengan trem, semuanya dicoba untuk memastikan bahwa sistem otonom dapat merespons dengan cepat dan efektif. Pengujian ini bertujuan untuk memvalidasi kemampuan sistem otonom dalam mendeteksi dan menghindari rintangan-rintangan tersebut.

Hasil pengujian menunjukkan bahwa sistem otonomi bekerja dengan baik dan sesuai dengan harapan. Selama pengujian, proses pengereman trem, percepatan, dan pengaturan batas kecepatan beroperasi secara efisien dan sesuai dengan parameter yang telah ditentukan. Kemampuan sistem untuk mengidentifikasi dan merespons terhadap obastacle, termasuk pejalan kaki, sepeda motor, dan mobil, memberikan keyakinan bahwa teknologi otonom pada trem ini dapat diandalkan dan aman untuk diimplementasikan dalam situasi lalu lintas sehari-hari. Pengujian di jalan raya sebenarnya memberikan validasi nyata terhadap kehandalan dan keamanan sistem otonom. Hasil positif dari pengujian ini memberikan landasan yang kokoh untuk melanjutkan pengembangan dan implementasi trem otonom secara lebih luas, serta memberikan kontribusi penting terhadap perkembangan teknologi otonom di sektor transportasi.

Selain itu dilakukan pengujian pada saat kendaraan trem otonom berjalan disepanjang rel. Pada pengujian ini akan ada pejalan kaki yang berdiri dalam keadaan diam diatas rel didepan trem otonom. Keluaran sistem persepsi deteksi objek berbasis fusi kamera – LiDAR ini dikirim kepada sistem pengambilan keputusan trem otonom. Hasil pengujian ini ditampilkan pada Gambar 14, berdasarkan gambar tersebut menunjukkan sistem persepsi deteksi objek berbasis fusi kamera – LiDAR berhasil mendeteksi objek pejalan kaki yang diam berdiri didepan kendaraan trem otonom. Keluaran hasil deteksi ini berupa posisi objek pada koordinat tiga dimensi LiDAR dikirimkan ke sistem pengambilan keputusan. Sehingga pada saat objek berada dijarak kurang dari 20 meter, maka trem otonom akan memberikan aksi pengereman darurat atau Emergency Braking System (EBS).

F. Manfaat, Tantangan, dan Harapan

Terdapat banyak manfaat yang didapat dari penerapan teknologi ini, antara lain :

- Keamanan dan Keselamatan: Penggunaan teknologi otonom dapat mengurangi risiko kecelakaan yang disebabkan oleh faktor manusia. Sistem ini dapat merespons dengan cepat terhadap situasi darurat dan mengambil tindakan yang diperlukan untuk mencegah kecelakaan.

- Efisiensi Transportasi: Trem otonom dapat diatur dengan lebih baik dalam hal jadwal perjalanan dan rute, mengurangi kemacetan dan waktu tunggu. Hal ini akan memberikan kontribusi besar terhadap efisiensi transportasi perkotaan.

- Pengurangan Emisi Gas Rumah Kaca: Dengan penggunaan teknologi ramah lingkungan, sistem autonomous trem dapat membantu mengurangi emisi gas rumah kaca yang dihasilkan oleh transportasi tradisional.

- Pemberdayaan Teknologi Lokal: Kolaborasi antara ITB dan PT INKA juga memberikan dorongan pada pemberdayaan teknologi lokal di Indonesia. Pengembangan dan produksi sistem autonomous trem di dalam negeri akan menciptakan lapangan kerja dan meningkatkan kapasitas industri teknologi di tanah air.

Meskipun proyek ini menjanjikan banyak potensi, masih ada beberapa tantangan yang perlu diatasi, seperti regulasi, penerimaan masyarakat, dan pengembangan infrastruktur pendukung. Dengan kolaborasi yang solid antara akademisi dengan industri dan didukung oleh pemerintah, diharapkan proyek ini dapat menjadi model untuk pengembangan teknologi transportasi otonom yang canggih di Indonesia.

G. Kesimpulan

Berdasarkan hasil penelitian yang sudah dilaksanakan, dapat diambil beberapa kesimpulan yang diuraikan sebagai berikut :

- Pengembangan arsitektur sistem fully autonomous dengan sistem persepsi deteksi objek 3D berbasis fusi kamera dan LiDAR dengan memangaatkan algoritma fuzzy untuk kendaraan otonom berhasil dilakukan.

- Implementasi metode fusi kamera – LiDAR pada komputer embedded mampu mendeteksi objek disekitar kendaraan otonom dengan baik bahkan pada kondisi pencahayaan gelap dan hujan, yang dapat digunakan oleh sistem pengambilan keputusan pada kendaraan otonom.

- Inisiatif kolaboratif antara ITB dan PT INKA dalam mengembangkan sistem autonomous trem menjadi contoh bagaimana kerjasama antara akademisi dan industri dapat menciptakan solusi inovatif untuk meningkatkan kualitas hidup masyarakat. Sistem ini bukan hanya akan memajukan dunia transportasi, tetapi juga memperkuat posisi Indonesia dalam kancah teknologi global. Melalui upaya bersama ini, diharapkan Indonesia dapat menjadi pelopor dalam penerapan teknologi otonom di sektor transportasi.

H. Ucapan Terima Kasih

Kami ingin mengucapkan terima kasih yang tulus kepada semua pihak yang telah memberikan dukungan dan kontribusi berarti dalam kelancaran pengembangan sistem trem autonomous ini. Terima kasih kepada pemerintah Indonesia, khususnya LPDP, atas dukungan keuangan yang telah memberikan fondasi yang kuat bagi penelitian ini. Dana yang diberikan oleh LPDP selama tiga tahun menjadi pendorong utama dalam mewujudkan inovasi ini. Kepercayaan dan dukungan dari pemerintah adalah kunci kesuksesan kami dalam mengatasi tantangan teknis dan logistik yang dihadapi dalam pengembangan sistem ini. Ucapan terima kasih juga kami sampaikan kepada seluruh tim penelitian, mitra industri, dan semua individu yang telah berkontribusi dengan dedikasi dan semangat tinggi. Semua pihak ini, bersama-sama, membentuk fondasi yang kokoh untuk memajukan teknologi transportasi masa depan.

I. Daftar Pustaka

- A. Kim, A., A. Osa, L. Taixee, “EagerMot : 3D Multi Object Tracking via Sensor Fusion”, IEEE International Conference on Robotics and Automation, 2021

- Mohammed Elgendy, “Deep Learning for Vision Systems”, Manning, 2020

- Francois Chollet, “Deep Learning with Python”, Manning, 2021

- Aston Zhang dkk, “Dive into Deep Learning”, 2022 (https://d2l.ai)

- C. Di Palma, V. Galdi, V. Calderaro, F. De Luca, F., “Driver Assistance System for Trams: Smart Tram in Smart Cities”, 2020 IEEE International Conference on Environment and Electrical Engineering, 2020

- K. Doherty, D. Fourie, J. Leonard, “Multimodal Semantic SLAM with Probabilistic Data Association”, International Conference on Robotics and Automation (ICRA), 2019

- Y. Dong, S. Wang, J. Yue, J., C. Chen, S. He, H. Wang, B. He, B., “A Novel Texture-Less Object Oriented Visual SLAM System”, IEEE Transactions on Intelligent Transportation Systems, 2019, 1-14.

- D. Frost, V. Prisacariu, D. Murray, “Recovering Stable Scale in Monocular SLAM Using Object-Supplemented Bundle Adjustment”, IEEE Transaction on Robotics, 2018, 34(3), 736-747.

- J. Harb, N. Rébéna, R. Chosidow, G. Roblin, R. Potarusov, H. Hajri, “FRSign: A Large-Scale Traffic Light Dataset for Autonomous Trains”, ArXiv preprint arXiv:2002.05665, 2020

- H. Liu, “Robot Systems for Rail Transit Applications”, Elsevier, 2020

- S. Liu, “Engineering Autonomous Vehicle and Robots: the Dragonfly Modular Based Approach”, Wiley, 2020

- I. Rusli, B.R. Trilaksono, W. Adiprawita, “RoomSLAM: Simultaneous Localization and Mapping with Objects and Indoor Layout Structure”, IEEE Access, 2020

- S. Raschka, dkk, “Machine Learning with Pytorch and ScikitLearn : Develop Machine Learning and Deep Learning Models with Python”, Packt Publishing, 2022

- Siemens, “Siemens Mobility on the Way to an Autonomous Tram”, 2019, https://assets.new.siemens.com/siemens/assets/api/uuid:9d7d12df-a30c-43bda06dbff6dfe96543/presentation-itpautonome-tram-e.pdf

- Siemens, “Teaching trams to drive. On the way to smart and autonomous trams: A Siemens Mobility research project, Siemens Mobility GmbH, 2019, https://assets.new.siemens.com/siemens/assets/api/uuid:bc2811c4-3d26-460d-9472-9372d5ce32d7/autonomous-tram.pdf

- Systra, “Automated and Autonomous Public Transport : Possibilities, Challenges and Technologies”, 2020, https://www.systra.com/wp-content/uploads/2020/09/systra-automated_and_autonomous_public_transport_2018.pdf

- A. Pohan, B.R. Trilaksono, S.P. Santosa, A.S. Rohman, “Path Planning Algorithm Using the Hybridization of Rapidly Random Tree and Ant Colony Systems, IEEE Access, 2021

- D. Parekh dkk., “A Review on Autonomous Vehicles : Progress, Methods, and Challenges”, Electronics, 2022, 11(14)

- Z. Zhu dkk, “Deep Learning for Autonomous Vehicle and Pedestrian Interaction Safety”, Safety Science, Vol. 145, 2022

- J. Ren dkk., “Applying Deep Learning for Autonomous Vehicles : A Survey”, 4th International Conference on Artificial Intelligence and Big Data, 2021

- S. Liu dkk, “Creating Autonomous Vehicle Systems”, Morgan & Claypool Publishers, 2020

- Alaba, S. Y., & Ball, J. E. (2022). A survey on deep-learning-based lidar 3d object detection for autonomous driving. Sensors, 22(24), 9577

- Wang, Z., Wu, Y., & Niu, Q. (2019). Multi-sensor fusion in automated driving: A survey. IEEE Access, 8, 2847-2868.

- Pang, S., Morris, D., & Radha, H. (2020). CLOCs: Camera-LiDAR object candidates fusion for 3D object detection. In 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS) (pp. 10386-10393). IEEE.

- Yan, Y., Mao, Y., & Li, B. (2018). Second: Sparsely embedded convolutional detection. Sensors, 18(10), 3337.

- Redmon, J., Divvala, S., Girshick, R., & Farhadi, A. (2016). You only look once: Unified, real-time object detection. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 779-788).